Da li će biti kao u filmovima: Nova studija otkriva da li je veštačka inteligencija pretnja čovečanstvu

Istraživanje je objavljeno u dnevniku radova 62. godišnje skupštine međunarodnog Udruženja za računarsku lingvistiku (ACL)

Foto: Profimedia

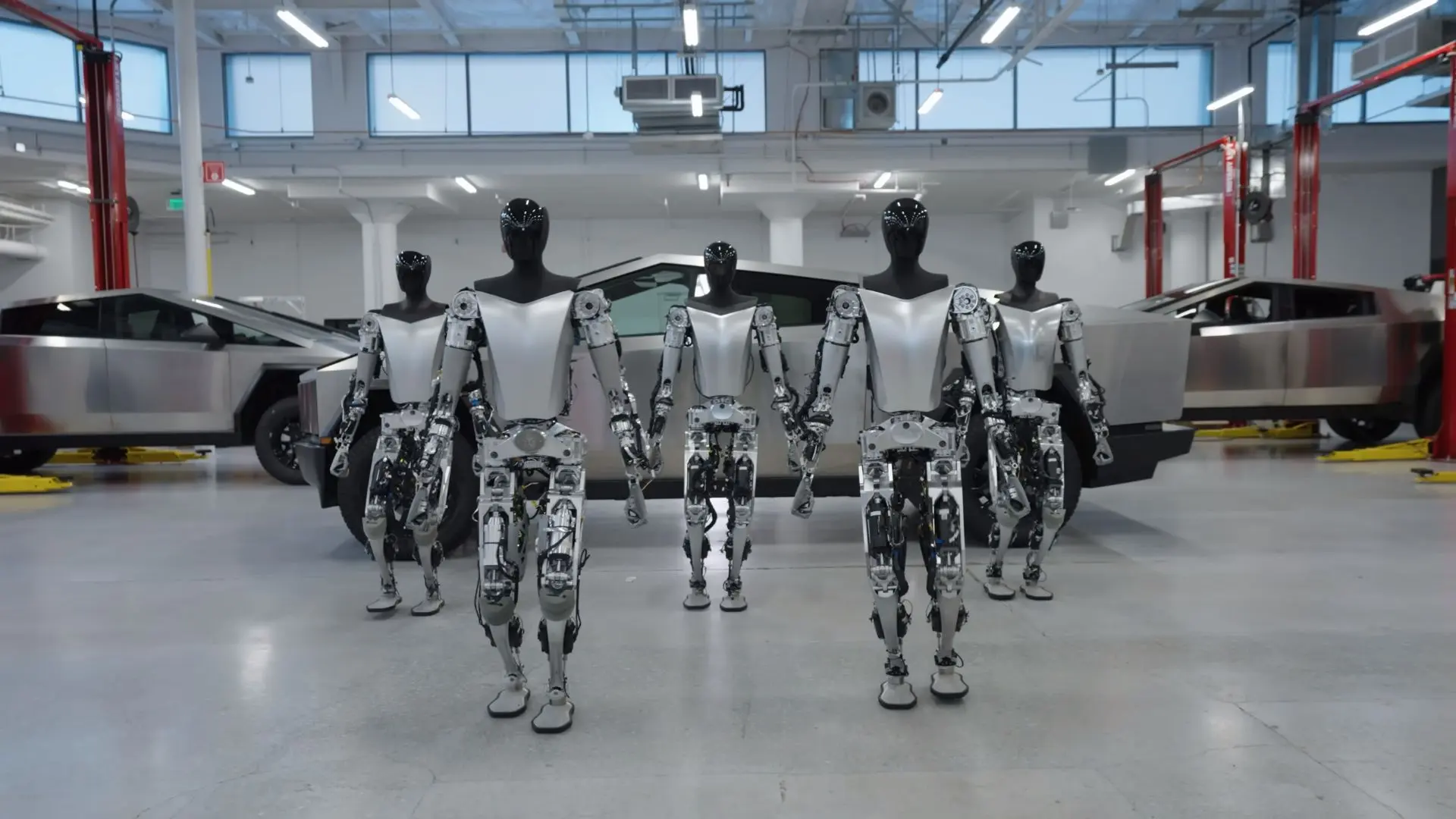

Foto: ProfimediaNaučna fantastika često prikazuje veštačku inteligenciju kao pretnju čovečanstvu, sa scenarijima poput HAL-9000 (2001: Odiseja u svemiru) i Skyneta (Terminator franšiza) koji naglašavaju strah od mašina koje će se okrenuti protiv svojih kreatora. Danas, s porastom sofisticiranih velikih jezičnih modela (LLM-ova) kao što je ChatGPT, te brige su postale relevantnije.

Međutim, nova studija koju su vodili računarski naučnici Irina Gurevič s Tehničkog univerziteta u Darmštatuu u Nemačkoj i Hariš Tajar Madabuši sa Univerziteta u Batu u Velikoj Britaniji, donosi umirujuće vesti. Studija zaključuje da ti LLM modeli nisu sposobni da se otuđe, s obzirom na to da su previše ograničeni svojim programiranjem da razviju nove sposobnosti bez čovekovih instrukcija.

Neopravdani strah i nedostatak istinske inteligencije

"Strah je bio da će, kako modeli postaju sve veći i veći, moći da reše nove probleme koje trenutno ne možemo da predvidimo, što predstavlja pretnju da bi ti veći modeli mogli da steknu opasne sposobnosti, uključujući razmišljanje i planiranje. Naša studija pokazuje da strah da će se LLM model oteti kontroli i učiniti nešto potpuno neočekivano, inovativno i potencijalno opasno nije opravdan", objašnjava Tajar Madabuši.

Uprkos značajnom napretku u LLM tehnologiji, koji sada može da učestvuje u koherentnim tekstualnim razgovorima oponašajući ljudsku interakciju, još uvek joj nedostaje istinska inteligencija. LLM modeli mogu uverljivo da prenesu netačne informacije, ali to je zbog ograničenja u obradi, a ne zbog autonomnog zaključivanja.

Kontrola procesa učenja

Naučnici su nedavno istražili ideju o "nastajućim sposobnostima" u LLM modelima, odnosno veštinama koje bi mogle da se razviju nezavisno od njihovog programiranja. Međutim, eksperimenti studije s četiri različita LLM-a nisu pronašli dokaze o takvom autonomnom ponašanju. Prikazane sposobnosti objašnjene su sposobnošću modela za praćenje uputstava, pamćenje i lingvističkim sposobnostima, bez znakova nezavisnih ili nepredviđenih radnji.

"Naši rezultati ne znače da veštačka inteligencija uopšte nije pretnja... Ipak možemo veoma dobro da kontrolišemo proces učenja LLM-a. Buduća istraživanja bi zato trebalo da se fokusiraju na druge rizike koje predstavljaju modeli, kao što je njihov potencijal korišćenja za stvaranje lažnih vesti", pojašnjava Gurevič.

Istraživanje je objavljeno u dnevniku radova 62. godišnje skupštine međunarodnog Udruženja za računarsku lingvistiku (ACL).

Ostavite Vaš komentar:

NAPOMENA: Komentarisanje vesti na portalu UNA.RS je anonimno, a registracija nije potrebna. Komentari koji sadrže psovke, uvrede, pretnje i govor mržnje na nacionalnoj, verskoj, rasnoj osnovi ili povodom nečije seksualne opredeljenosti neće biti objavljeni. Komentari odražavaju stavove isključivo njihovih autora, koji zbog govora mržnje mogu biti i krivično gonjeni. Kao čitatelj prihvatate mogućnost da među komentarima mogu biti pronađeni sadržaji koji mogu biti u suprotnosti sa Vašim načelima i uverenjima. Nije dozvoljeno postavljanje linkova i promovisanjedrugih sajtova kroz komentare.

Svaki korisnik pre pisanja komentara mora se upoznati sa Pravilima i uslovima korišćenja komentara. Slanjem komentara prihvatate Politiku privatnosti.

Komentari ()

- Najnovije

- Najčitanije

- Povezano

Srbija u EU do 2035. godine: Vizija modernog zdravstva, novog obrazovanja i povratka ljudi iz inostranstva

Pre 3 min

Karleuša se oglasila o turskom milioneru na kog je "bacila oko": "Vrlo je zgodan"

Pre 8 min

Formula 1: Rasel osvojio pol poziciju za prvu trku u ovogodišnjem šampionatu

Pre 10 min

Goldman Saks upozorava: Nafta ide preko 100 dolara već sledeće nedelje, preti nam kriza gora od 2008. godine

Pre 13 min

"Iran je pred potpunim uništenjem": Tramp tvrdi da je Teheran obećao prekid napada na susedne zemlje

Pre 23 min

Prekinite da zalivate biljke ovako: Jedna greška ih pretvara u suvo granje za samo nekoliko dana

Pre 28 min

Komemoracija Aleksandru Boričiću održana na stadionu "Rajko Mitić"

Pre 30 min